se diversi tipi di intelligenza artificiale dovessero scontrarsi tra loro, ciò potrebbe diventare un problema? Google DeepMind ha rispostp con dei giochi.

Uno studio condotto dalla divisione DeepMind di Google dimostra che l’Intelligenza Artificiale (AI) sarebbe in grado di fare pressoché tutto: dal sognare al creare lingue artificiali. Questa tecnologia non fa che diventare sempre più smart, quasi più di noi.

Il tessuto della nostra società digitale è sempre più gestito e controllato dall’ AI – sia che si tratti di controllare i semafori di una città, una società, un sistema finanziario in esecuzione o l’esercito americano. Ma se diversi tipi di intelligenza artificiale dovessero scontrarsi tra loro, ciò potrebbe diventare un problema?

I più scrupolosi si domandano: questi agenti di AI saranno reciprocamente corretti? Cosa potrebbe succedere in caso di conflitti tra sistemi?

Il team di DeepMind ha cercato delle risposte, tramite uno studio che ha messo insieme una serie di dilemmi di tipo sociale, chiedendo ad agenti di AI di trovare delle soluzioni. In pratica, sono state create delle situazioni in grado di testare il modo in cui gli agenti si sarebbero potuti porre nel caso in cui si fossero trovati a potersi tradire reciprocamente a fronte di una ricompensa.

In un post nel blog di DeepMind è stato illustrato come i ricercatori abbiano testato l’AI in situazioni ipotetiche per mezzo di due videogame.

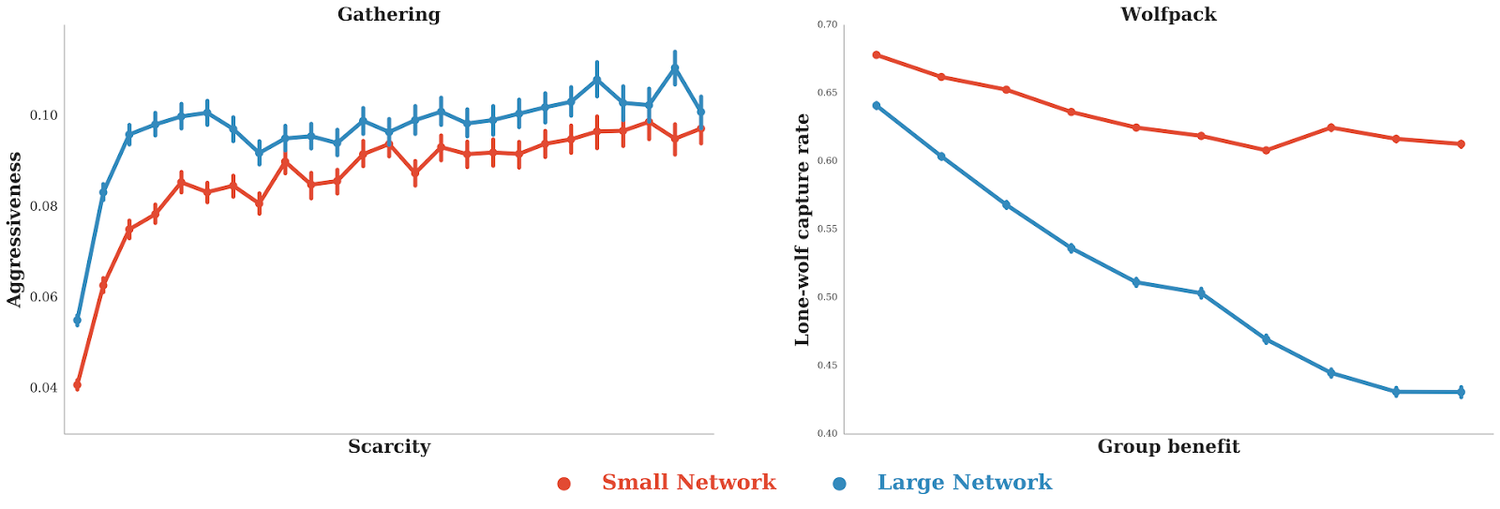

Nel primo gioco che sia chiama “Gathering”, due agenti dovevano raccogliere mele da un mucchio, entrambi avevano la possibilità di mirare l’agente avversario con un raggio laser, rimuovendolo temporaneamente dal gioco in modo da assicurarsi di poter raccogliere più mele.

Nel secondo gioco “Wolfpack” due agenti devono cacciarne un terzo in un ambiente pieno di ostacoli, i punti vengono ottenuti non solo quando un agente cattura la preda, ma anche quando tutti gli altri agenti sono vicino alla preda e quando poi questa viene catturata. Quello che hanno scoperto i ricercatori è piuttosto interessante, ma forse non sorprendente: gli agenti hanno cambiato comportamento diventando sia cooperativi che antagonistici, in base all’obiettivo.

Ad esempio, nel gioco Gathering quando le mele erano state raccolte in abbondanza, agli agenti non interessava colpire l’avversario con il laser, ma quando le scorte scarseggiavano il numero di raggi per colpire aumentava, accrescendo la competitività tra i due agenti. Ancor più interessante è che quando un agente era più potente nel calcolo, aumentava la frequenza dei raggi, mentre l’agente più debole -indipendentemente dal numero di mele – era meno aggressivo.

I ricercatori de DeepMind ipotizzano che l’aumento di raggi nel comportamento da parte del più potente, e quindi dell’AI avanzata, fosse semplicemente dovuto al fatto che fare un tracking dell’avversario fosse più impegnativo e intenso a livello computazionale. L’agente doveva puntare la sua arma verso l’altro giocatore e monitorare i movimenti, attività che richiedono maggiore potenza di calcolo. In questo modo veniva data più potenza di calcolo all’intelligenza artificiale più potente, consentendo di poter ideare più soluzioni anche a costo di sprecare energie delle quali, comunque disponeva, di pari passo, insistere con un avversario di per sé debole rendeva più vantaggiosa la cooperazione, anche solo in termini di risparmio di risorse.

Al contrario, in Wolfpack, l’agente di AI più potente e avanzato, cooperava con gli altri agenti. Come spiegano i ricercatori, questo è perché imparare a lavorare con l’altro giocatore per tenere traccia della preda richiede più potenza di calcolo.

I risultati dello studio DeepMind hanno dimostrato come il comportamento degli agenti di AI venga modificato in base alle regole che si trova ad affrontare. Se tali regole premiano i comportamenti aggressivi, come ad esempio in Gathering, gli agenti saranno più aggressivi, ma se le regole della ricompensa comportano una cooperazione, allora il sistema si porrà in modo più cooperativo.

Ciò significa che parte della sfida nel controllo gli agenti di AI, in futuro, comporterà assicurarsi che le giuste regole siano state impostate a dovere. Ma se l’intelligenza artificiale diventa sempre più complessa, e sempre più integrata al nostro complicato tessuto digitale, potrebbe essere una sfida impossibile controllare le nostre creazioni a fin di bene. Ma allora che cosa succederebbe?

I ricercatori hanno voluto sottolineare che “A seguito di questa ricerca potremmo essere in grado di capire e controllare i sistemi complessi multi-agente come quelli applicati nell’economia, nei sistemi di traffico, o nell’ecologia per ottenere un pianeta migliore. Tutti questi sistemi dipendono dalla nostra continua cooperazione”.