Alcuni ricercatori hanno realizzato un sistema in grado di ricreare movimenti realistici a partire da un singolo fotogramma del volto di una persona, aprendo la possibilità di animare non solo le foto ma anche i quadri. Non è perfetto, ma quando funziona, è – come molta intelligenza artificiale di questi tempi – inquietante e allo stesso tempo affascinante.

L’intelligenza artificiale dà vita all’arte e in particolare alla misteriosa Monna Lisa di Leonardo Da Vinci, che diventa viva in un video. Grazie all’intelligenza artificiale, infatti, è possibile vedere dipinti e foto muoversi e, per così dire, prendere vita. Alcuni ricercatori hanno realizzato infatti un sistema in grado di ricreare movimenti realistici da un singolo fotogramma del volto di una persona, aprendo la possibilità di animare non solo le foto ma anche i quadri. Non è perfetto, ma quando funziona, è – come molta intelligenza artificiale di questi tempi – inquietante e allo stesso tempo affascinante.

L’intelligenza artificiale dà vita all’arte: come funziona il modello

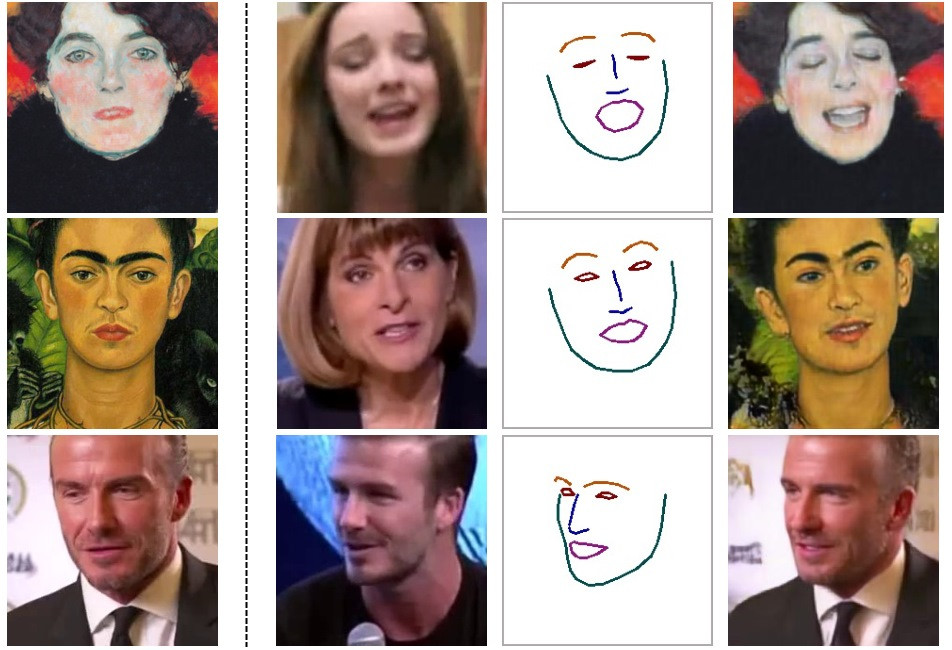

Il modello è illustrato in un documento pubblicato dal Samsung AI Center, reperibile su Arxiv. Si tratta di un nuovo metodo di applicazione di punti di riferimento facciali su un viso sorgente ai dati facciali di un viso di destinazione, facendo sì che il volto target faccia quello che fa il volto sorgente.

La cosa di per sé non è nuova; fa parte della grande questione delle immagini sintetiche che il mondo dell’intelligenza artificiale in questo periodo sta affrontando; possiamo già realizzare il video di un volto che rifletta il volto di un’altra persona in termini di ciò che la persona sta dicendo o dove sta guardando, ma la maggior parte di questi modelli richiede una notevole quantità di dati, circa un minuto o due di video da analizzare.

Grazie al lavoro dei ricercatori di Samsung a Mosca, invece, si può generare il video di un volto che gira, parla e fa espressioni con una fedeltà abbastanza convincente (sebbene lungi dall’impeccabile) a partire da una sola immagine. E questo permette di animare, per esempio, i volti delle opere d’arte.

Il meccanismo riesce in questa impresa tramite un processo di identificazione dei punti di riferimento facciali con un’enorme quantità di dati, rendendo il modello altamente efficiente nel trovare le parti del volto di destinazione che corrispondono alla fonte. Più dati ha, meglio riesce, ma può farlo anche con una sola immagine. In pratica, si può scattare una foto di Einstein o di Marilyn Monroe, o anche della Gioconda, e farle muovere e parlare come persone reali.

Il sistema utilizza anche quello che viene definito un Generative Adversarial Network, che sostanzialmente mette a confronto due modelli, di cui uno cerca di convincere l’altro che l’immagine realizzata corrisponde al mondo reale. Con questi metodi i risultati raggiungono un certo livello di realismo; il modello “discriminatore” dev’essere, per esempio, sicuro al 90% che si tratti di un volto umano perché il processo continui.

I risultati sono variabili

Negli altri esempi forniti dai ricercatori, la qualità e l’ovvietà o meno della falsità dei volti creati varia ampiamente. Alcuni, per esempio, tentano di replicare una persona la cui immagine è stata presa da notiziari e ricreano anche il ticker delle notizie mostrato nella parte inferiore dell’immagine, riempiendolo di parole senza senso.

Ad ogni modo, il fatto che il sistema raggiunga risultati anche solo parzialmente credibili è straordinario. Si noti, tuttavia, che il meccanismo funziona solo sul viso e sulla parte superiore del busto e che non è possibile far muovere le dita o far ballare la Gioconda. O almeno non ancora.