Google pubblica una metodologia “full-stack” per misurare quanto consuma un prompt di Google Gemini: energia, CO₂ e acqua. Confronto con altri vendor, criticità e cosa fare in Italia.

Quanta energia consuma un prompt di Google Gemini? La domanda è molto rilevante perchè, inutile nasconderlo, l’intelligenza artificiale ha un problema di sostenibilità. Ogni volta che chiedi a ChatGPT di scrivere un email o a Gemini di riassumerti un articolo, da qualche parte nel mondo un processore scalda, un ventilatore gira, e l’elettricità scorre. Ma quanto esattamente? Fino a ieri erano tutti conti approssimativi, stime o calcoli teorici che facevano più rumore che chiarezza.

Oggi Google cambia le carte in tavola. Per la prima volta un big tech pubblica numeri precisi su quanto energia consuma davvero un singolo prompt testuale in Gemini e i dati sono sorprendenti: parliamo di 0,24 wattora per una richiesta in media, l’equivalente di guardare la TV per meno di 9 secondi.

Indice dei contenuti

Quanta energia consuma un prompt Google: poco nel dettaglio, tanto sommati

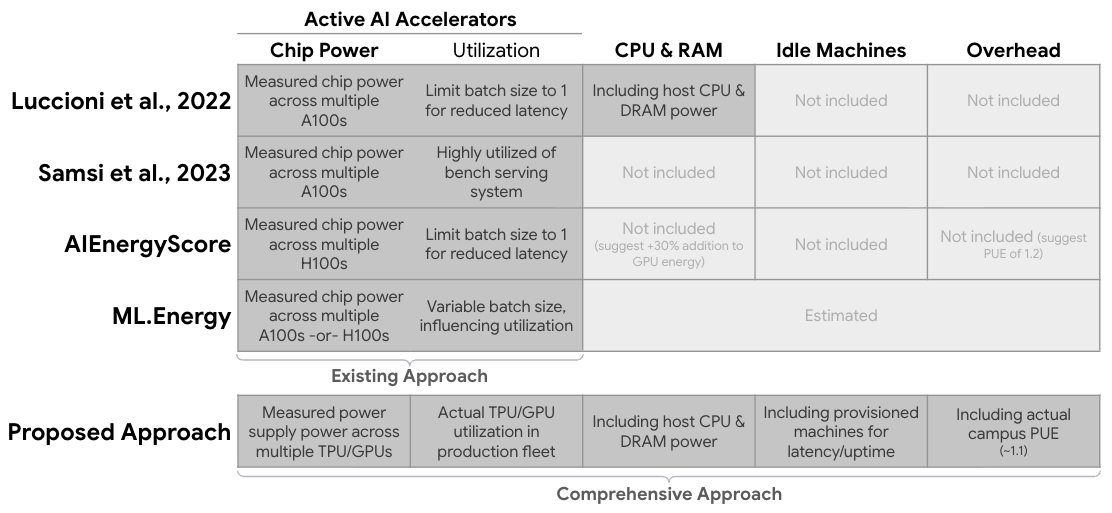

La metodologia che Google ha sviluppato si chiama “full-stack” ed è molto più completa di quello che avevamo visto finora. Non si limita a misurare il consumo dei chip GPU o TPU durante il calcolo, ma include tutto: le CPU e la RAM dei server, le macchine che stanno in standby per garantire disponibilità, e anche l’overhead del data center.

Per un prompt testuale mediano in Gemini Apps, i numeri sono questi:

- Energia: 0,24 wattora (come guardare la TV per 8,6 secondi)

- Emissioni di CO2: 0,03 grammi di CO2 equivalente

- Acqua: 0,26 millilitri (circa cinque gocce)

Quello che colpisce è il miglioramento: in 12 mesi, l’energia e l’impronta di carbonio del prompt mediano sono diminuiti di 33 e 44 volte rispettivamente. Merito di ottimizzazioni lungo tutta la filiera: algoritmi più efficienti, hardware specializzato come le TPU, tecniche avanzate come il mixture of experts (MoE) e la quantizzazione, e data center con un power usage effectiveness (PUE) medio di 1,09 nel 2024.

Il confronto con la concorrenza (e perché è complicato)

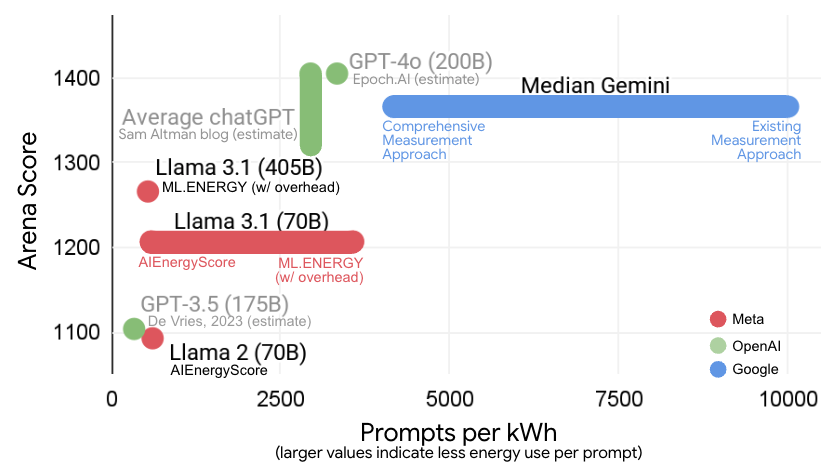

Sam Altman di OpenAI aveva dichiarato che una query media di ChatGPT usa circa 0,34 wattora e 0,32 millilitri d’acqua. Numeri simili a quelli di Google, ma senza una metodologia pubblica dettagliata. Non sappiamo se include lo stesso perimetro di misurazione, quali fattori di conversione usa, o come gestisce il mix energetico.

Mistral ha pubblicato uno studio peer-reviewed per Mistral Large 2: una risposta da 400 token consuma 1,14 grammi di CO2 equivalente e 45 millilitri d’acqua. Dato molto più “pesante”, ma qui la metodologia è diversa – è un’analisi del ciclo di vita completa con confini più ampi.

Il problema è proprio questo: senza standard comuni, confrontare “Gemini vs GPT vs Llama” è come paragonare consumi auto misurati con cicli diversi. Ogni azienda sceglie cosa includere nel calcolo, e il risultato può variare di un fattore multiplo.

Le critiche (giuste) e i punti deboli

Non tutti hanno accolto i numeri di Google senza riserve. Diverse criticità sono emerse nelle ore successive alla pubblicazione.

Primo, Google usa fattori di emissione “market-based” invece che “location-based”. Significa che conteggia i propri acquisti di energia pulita invece di considerare il mix energetico reale della rete elettrica locale. È una scelta legittima dal punto di vista aziendale, ma può portare a sottostimare l’impatto reale.

Secondo, l’acqua. Quelle 0,26 gocce considerano solo il water usage effectiveness (WUE) del data center, ma non l’acqua consumata per generare l’elettricità a monte. In certe regioni, questo può essere un fattore significativo.

Terzo, il perimetro limitato. La misurazione riguarda solo prompt testuali in Gemini Apps, non include immagini o video, non misura l’addestramento dei modelli (che resta la parte più energivora), e non copre rete e dispositivi utente.

Il paradosso dell’efficienza: quando migliorare non basta

Qui arriva il punto cruciale. L’efficienza per prompt è migliorata enormemente, ma la scala d’uso sta crescendo ancora più in fretta. È il pradosso di Jevons applicato al calcolo: quando rendi più efficiente una tecnologia, spesso finisci per usarla di più, non di meno.

L’International Energy Agency stima che i consumi elettrici globali dei data center raddoppieranno a 945 TWh entro il 2030. Gli AI-data center potrebbero quadruplicare il proprio fabbisogno nello stesso periodo. Mentre celebriamo le cinque gocce per prompt, i big tech firmano accordi per nuova potenza nucleare e – in alcuni casi – accettano anche nuove centrali a gas.

Google stesso riporta una riduzione delle emissioni energetiche dei propri data center del 12% nel 2024, ma con elettricità consumata in crescita del 27% anno su anno. La decarbonizzazione della fornitura sta funzionando, ma la domanda AI cresce più velocemente.

Quanta energia consuma un prompt di Google Gemini e cosa significa per chi usa l’AI

Dal punto di vista pratico, questi numeri cambiano qualcosa? Per l’utente individuale, probabilmente no. Che il tuo prompt consumi 0,24 o 0,34 wattora fa poca differenza nella bolletta del pianeta. Ma se sei un’azienda che processa migliaia di richieste al giorno, o un developer che integra AI nei prodotti, la storia cambia.

La sostenibilità dell’AI si gioca su tre assi:

- Quanto la usiamo (domanda)

- Come la serviamo (efficienza tecnica)

- Con che energia la alimentiamo (mix energetico)

Sul secondo punto, le strategie sono chiare: usare il modello giusto per il compito giusto (Gemini Flash invece di Pro per task semplici), ottimizzare i prompt, sfruttare batching e caching nell’integrazione, scegliere region con mix elettrico più pulito.

La trasparenza che mancava nel consumo di energia di un prompt

Al di là dei numeri specifici, l’iniziativa di Google ha un valore metodologico importante. Per la prima volta un big tech allarga il perimetro di calcolo oltre il chip, misura su flotta reale, dichiara PUE e WUE medi, e condivide una metrica operativa verificabile.

È il tipo di trasparenza che serve al settore. Se vogliamo discutere seriamente di sostenibilità nell’AI, abbiamo bisogno di:

- Confini espliciti e comparabili

- Breakdown per caso d’uso (testo, immagine, video hanno profili diversi)

- Numeri verificati da terze parti indipendenti

- Trasparenza energetica locale (location-based accanto ai market-based)

Il futuro dell’AI sostenibile

L’intelligenza artificiale non è intrinsecamente insostenibile, ma scalare a miliardi di utenti richiede scelte strategiche precise sull’energia. I big tech lo sanno, e infatti stanno investendo massicciamente in nucleare avanzato, energie rinnovabili e tecnologie di stoccaggio.

La vera innovazione non è far costare meno energia un prompt – è far sì che miliardi di prompt non costino al pianeta più di quanto ci possano restituire in termini di produttività, creatività e progresso.

Google oggi ci dà gli strumenti per misurare questa equazione. Ora tocca al settore usarli, e agli utenti fare scelte consapevoli. Perché l’AI sarà sostenibile non quando consumerà zero energia – impossibile – ma quando l’energia che consuma sarà pulita, misurata e giustificata dal valore che crea.