L’intelligenza artificiale comprende davvero? Secondo John Searle no, e porta il test della “stanza cinese”. Dennett, invece, enfatizza la funzionalità dell’IA piuttosto che la coscienza

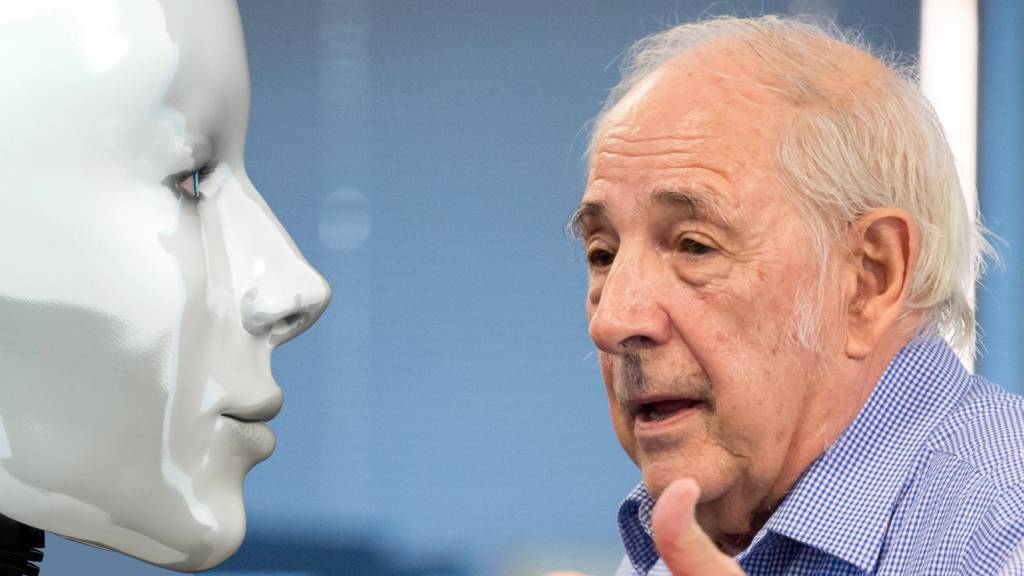

John Searle, noto filosofo americano, ha avuto un ruolo significativo nel dibattito sulla natura e il potenziale dell’intelligenza artificiale (AI). Nel suo lavoro, ha esplorato la questione centrale se un computer o una macchina può ragionare o comprendere.

Visualizza questo post su Instagram

L’intelligenza artificiale non capisce niente: la Stanza Cinese

Searle è forse meglio conosciuto per il suo esperimento mentale chiamato “l’argomento della Stanza Cinese”. Questo esperimento mette in discussione l’idea che un computer possa comprendere.

Il test ipotizza in un uomo all’interno di una stanza che riceve foglietti scritti in cinese da una fessura sulla porta. L’uomo non capisce il cinese, ma ha un libro di istruzioni che gli dice come rispondere a ogni possibile combinazione di caratteri cinesi. All’esterno della stanza, le persone vedrebbero i fogli in uscita e penserebbero che qualcuno dentro la stanza capisca il cinese. In realtà il soggetto sta solo seguendo istruzioni.

Questo è analogo a come un computer esegue un programma. Searle sostiene che, proprio come l’uomo nella stanza, un computer non capisce davvero le informazioni che sta elaborando. Segue solo un insieme di regole predefinite.

Intelligenza artificiale forte e debole

John Searle identifica due diverse concezioni dell’IA: intelligenza artificiale forte (Strong AI) e debole (Weak AI).

La “Strong AI” afferma che le macchine possono davvero pensare e avere una mente. Secondo questa visione, una macchina con sufficiente potenza e giusta programmazione potrebbe davvero capire, apprendere e rispondere alle informazioni come un essere umano.

Searle è molto critico nei confronti della Strong AI. Nonostante un programma possa simulare il comportamento umano, non significa che capisca davvero ciò che sta facendo.

La “Weak AI”, di cui Searle è un sostenitore, prevede che le macchine possano simulare il pensiero umano senza possederlo. Questo significa che un computer può essere programmato per eseguire compiti complessi e dare risposte intelligenti, ma non sarà mai autocosciente.

La posizione di Searle sull’intelligenza artificialepuò essere vista come un avversario positivo per il campo dell’AI sfidando i ricercatori a dimostrare non solo che un computer può sembrare intelligente, ma anche a capire cosa significhi veramente per una macchina “comprendere”.

Invece, secondo il filosofo Daniel C. Dennet la coscienza o autocoscienza è una questione di poca importanza. Per Dennett, il fatto che una macchina possa effettivamente ‘pensare’ o essere ‘cosciente’ è meno rilevante di quanto si possa immaginare. Invece di chiedersi se un’IA ha una mente in senso classico, Dennett suggerisce di concentrarsi su ciò che un’IA può effettivamente fare; ovvero, la sua capacità di apprendere, adattarsi, risolvere problemi e contribuire alla cognizione umana. Dennett vede l’intelligenza artificiale nient’altro che come un’estensione dei processi cognitivi umani, sottolinea che la IA non dovrebbe essere vista solo come un replica della pensiero, ma piuttosto come uno strumento che aiuta l’umanità ad estendere le proprie capacità cognitive.